115937

•

20-minütige Lektüre

•

Der PageRank-Algorithmus (oder kurz PR) ist ein System zum Ranking von Webseiten, das Ende der 90er Jahre von Larry Page und Sergey Brin an der Stanford University entwickelt wurde. PageRank war eigentlich die Grundlage, auf der Page und Brin die Google-Suchmaschine erstellten.

Seitdem sind viele Jahre vergangen und natürlich sind die Ranking-Algorithmen von Google viel komplizierter geworden. Basieren sie immer noch auf PageRank? Wie genau beeinflusst PageRank das Ranking, könnte dies einer der Gründe dafür sein, dass Ihre Rankings gesunken sind, und worauf sollten sich SEOs in Zukunft einstellen? Jetzt werden wir alle Fakten und Geheimnisse rund um PageRank herausfinden und zusammenfassen, um das Bild klarer zu machen. Nun, so viel wir können.

Wie oben erwähnt, versuchten Brin und Page in ihrem universitären Forschungsprojekt, ein System zur Schätzung der Autorität von Webseiten zu erfinden. Sie beschlossen, dieses System auf Links aufzubauen, die als Vertrauensbeweis für eine Seite dienten. Der Logik dieses Mechanismus zufolge sind die Informationen für Benutzer umso wertvoller, je mehr externe Ressourcen auf eine Seite verlinken. Und der PageRank (ein Wert von 0 bis 10, der auf der Grundlage der Quantität und Qualität der eingehenden Links berechnet wird) zeigte die relative Autorität einer Seite im Internet an.

Schauen wir uns an, wie PageRank funktioniert. Jeder Link von einer Seite (A) zu einer anderen (B) gibt eine sogenannte Stimme ab, deren Gewicht vom kollektiven Gewicht aller Seiten abhängt, die auf Seite A verlinken. Und wir können ihr Gewicht erst kennen, wenn wir es berechnen es, also verläuft der Prozess in Zyklen.

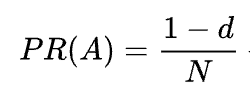

Die mathematische Formel des ursprünglichen PageRank lautet wie folgt:

Dabei sind A, B, C und D einige Seiten, L die Anzahl der von jeder Seite ausgehenden Links und N die Gesamtzahl der Seiten in der Sammlung (dh im Internet).

Bei d handelt es sich um den sogenannten Dämpfungsfaktor. Wenn man bedenkt, dass der PageRank berechnet wird, indem das Verhalten eines Benutzers simuliert wird, der zufällig auf eine Seite gelangt und auf Links klickt, wenden wir diesen Dämpfungsfaktor d als die Wahrscheinlichkeit an, dass sich der Benutzer langweilt und eine Seite verlässt.

Wie Sie der Formel entnehmen können, ist der PR nicht Null, wenn keine Seiten auf die Seite verweisen

Da die Wahrscheinlichkeit besteht, dass der Benutzer nicht über andere Seiten, sondern beispielsweise über Lesezeichen auf diese Seite gelangt.

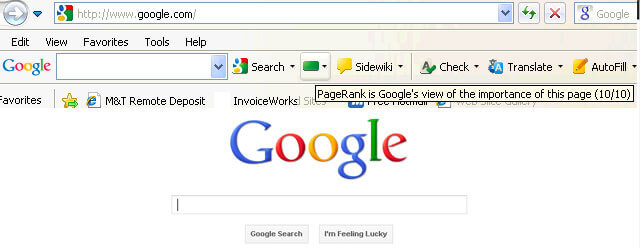

Zunächst war der PageRank-Score öffentlich in der Google Toolbar sichtbar und jede Seite hatte einen Score von 0 bis 10, höchstwahrscheinlich auf einer logarithmischen Skala.

Die damaligen Ranking-Algorithmen von Google waren wirklich einfach – eine hohe PR und Keyword-Dichte waren die einzigen beiden Dinge, die eine Seite brauchte, um in einer SERP einen hohen Rang zu erreichen. Infolgedessen waren Webseiten mit Schlüsselwörtern vollgestopft und Websitebesitzer begannen, den PageRank zu manipulieren, indem sie Spam-Backlinks künstlich vergrößerten. Das war einfach zu bewerkstelligen – Linkfarmen und Linkverkauf waren dazu da, Websitebesitzern eine „helfende Hand“ zu geben.

Google hat beschlossen, Link-Spam zu bekämpfen. Im Jahr 2003 bestrafte Google die Website des Werbenetzwerkunternehmens SearchKing wegen Linkmanipulationen. SearchKing verklagte Google, aber Google gewann. Auf diese Weise versuchte Google, jeden von Linkmanipulationen abzuhalten, führte jedoch zu nichts. Link-Farmen gingen einfach in den Untergrund und ihre Zahl vervielfachte sich enorm.

Außerdem vervielfachten sich auch die Spam-Kommentare auf Blogs. Bots griffen die Kommentare beispielsweise von WordPress-Blogs an und hinterließen enorme Mengen an „Klicken Sie hier, um magische Pillen zu kaufen“ -Kommentare. Um Spam und PR-Manipulation in Kommentaren zu verhindern, führte Google 2005 das Nofollow-Tag ein. Und wieder einmal wurde das, was Google als erfolgreicher Schritt im Link-Manipulationskrieg ansah, auf verdrehte Weise umgesetzt. Die Leute begannen, Nofollow-Tags zu verwenden, um PageRank künstlich auf die Seiten zu leiten, die sie brauchten. Diese Taktik wurde als PageRank-Sculpting bekannt.

Um PR-Sculpting zu verhindern, hat Google die Art und Weise geändert, wie der PageRank fließt. Wenn eine Seite bisher sowohl Nofollow-als auch Dofollow- Links hatte, wurde das gesamte PR-Volumen der Seite an andere Seiten weitergegeben, die mit den Dofollow-Links verlinkt waren. Im Jahr 2009 begann Google damit, die PR einer Seite gleichmäßig auf alle Links der Seite aufzuteilen, wobei jedoch nur die Anteile weitergegeben wurden, die an die Dofollow- Links vergeben wurden.

Als Google mit der PageRank-Bildung fertig war, stoppte es den Link-Spam-Krieg nicht und begann konsequent, den PageRank-Score aus der Öffentlichkeit zu streichen. Zunächst startete Google den neuen Chrome-Browser ohne Google Toolbar, in dem der PR-Score angezeigt wurde. Dann wurde die Meldung des PR-Scores in der Google Search Console eingestellt. Dann hat der Firefox-Browser die Unterstützung der Google Toolbar eingestellt. Im Jahr 2013 wurde PageRank zum letzten Mal für den Internet Explorer aktualisiert und im Jahr 2016 hat Google die Toolbar offiziell für die Öffentlichkeit eingestellt.

Eine weitere Möglichkeit, mit der Google Link-Schemata bekämpfte, war das Penguin-Update, das Websites mit verdächtigen Backlink-Profilen herabstufte. Penguin wurde 2012 eingeführt und wurde nicht Teil des Echtzeitalgorithmus von Google, sondern war vielmehr ein „Filter“, der von Zeit zu Zeit aktualisiert und erneut auf die Suchergebnisse angewendet wurde. Wenn eine Website von Penguin abgestraft wurde, mussten SEOs ihre Linkprofile sorgfältig überprüfen und toxische Links entfernen oder sie zu einer Disavow-Liste hinzufügen (eine Funktion, die damals eingeführt wurde, um Google mitzuteilen, welche eingehenden Links bei der Berechnung des PageRanks ignoriert werden sollen). Nachdem die Linkprofile auf diese Weise geprüft wurden, mussten SEOs etwa ein halbes Jahr warten, bis der Penguin-Algorithmus die Daten neu berechnete.

Im Jahr 2016 hat Google Penguin zu einem Teil seines zentralen Ranking-Algorithmus gemacht. Seitdem arbeitet es in Echtzeit und geht algorithmisch viel erfolgreicher mit Spam um.

Gleichzeitig hat Google daran gearbeitet, Qualität statt Quantität der Links zu fördern, und hat dies in seinen Qualitätsrichtlinien gegen Link-Schemata verankert.

Nun, wir sind mit der Vergangenheit von PageRank fertig. Was passiert jetzt?

Im Jahr 2019 sagte ein ehemaliger Google-Mitarbeiter, dass der ursprüngliche PageRank-Algorithmus seit 2006 nicht mehr verwendet worden sei und mit der Vergrößerung des Internets durch einen anderen, weniger ressourcenintensiven Algorithmus ersetzt worden sei. Das könnte durchaus stimmen, denn im Jahr 2006 meldete Google das neue Patent an.

Ja ist es. Es ist nicht mehr derselbe PageRank wie in den frühen 2000er Jahren, aber Google verlässt sich weiterhin stark auf die Linkautorität. Dies erwähnte beispielsweise ein ehemaliger Google-Mitarbeiter Andrey Lipattsev im Jahr 2016. In einem Google Q&A-Hangout fragte ihn ein Nutzer, was die wichtigsten Ranking-Signale seien, die Google verwendet habe. Andreys Antwort war ziemlich einfach.

Ich kann Ihnen sagen, was sie sind. Es handelt sich um Inhalte und Links, die auf Ihre Website verweisen.

Im Jahr 2020 bestätigte John Mueller erneut:

Ja, wir verwenden PageRank intern neben vielen, vielen anderen Signalen. Es ist nicht ganz dasselbe wie das Originalpapier, es gibt viele Macken (z. B. abgelehnte Links, ignorierte Links usw.) und wir verwenden wiederum viele andere Signale, die viel stärker sein können.

Wie Sie sehen, ist PageRank noch immer am Leben und wird von Google aktiv beim Ranking von Seiten im Web verwendet.

Interessant ist, dass Google-Mitarbeiter uns immer wieder daran erinnern, dass es viele, viele, VIELE andere Google-Ranking-Faktoren gibt. Aber wir betrachten das mit Vorsicht. Wenn man bedenkt, wie viel Mühe Google in die Bekämpfung von Link-Spam gesteckt hat, könnte es für Google von Interesse sein, die Aufmerksamkeit der SEOs von den manipulationsanfälligen Faktoren (wie Backlinks) abzulenken und diese Aufmerksamkeit auf etwas Unschuldiges und Nettes zu lenken. Da SEOs jedoch gut darin sind, zwischen den Zeilen zu lesen, betrachten sie PageRank weiterhin als starkes Ranking-Signal und bauen Backlinks auf allen möglichen Wegen aus. Sie verwenden immer noch PBNs, praktizieren mehrstufigen Linkaufbau, kaufen Links und so weiter, so wie es vor langer Zeit war. So wie PageRank weiterlebt, wird auch Link-Spam weiterleben. Wir empfehlen nichts davon, aber so sieht die SEO-Realität aus, und das müssen wir verstehen.

Nun, Sie haben den Eindruck, dass der PageRank heute nicht mehr der PageRank von vor 20 Jahren ist.

Eine der wichtigsten Modernisierungen der PR war der Übergang vom oben kurz erwähnten Random Surfer-Modell zum Reasonable Surfer-Modell im Jahr 2012. Reasonable Surfer geht davon aus, dass sich Benutzer auf einer Seite nicht chaotisch verhalten und nur auf die Links klicken, an denen sie interessiert sind Moment. Wenn Sie beispielsweise einen Blogartikel lesen, ist die Wahrscheinlichkeit höher, dass Sie auf einen Link im Inhalt des Artikels klicken, als auf den Link zu den Nutzungsbedingungen in der Fußzeile.

Darüber hinaus kann Reasonable Surfer bei der Bewertung der Attraktivität eines Links möglicherweise eine Vielzahl weiterer Faktoren heranziehen. Alle diese Faktoren wurden von Bill Slawski in seinem Artikel sorgfältig untersucht, ich möchte mich jedoch auf die beiden Faktoren konzentrieren, die SEOs häufiger diskutieren. Dies sind Linkposition und Seitenverkehr. Was können wir über diese Faktoren sagen?

Ein Link kann sich überall auf der Seite befinden – im Inhalt, im Navigationsmenü, in der Biografie des Autors, in der Fußzeile und eigentlich in jedem Strukturelement, das die Seite enthält. Und unterschiedliche Linkpositionen wirken sich auf den Linkwert aus. John Mueller bestätigte dies und sagte, dass die im Hauptinhalt platzierten Links mehr wiegen als alle anderen:

Dies ist der Bereich der Seite, in dem Sie Ihren Hauptinhalt haben, den Inhalt, um den es auf dieser Seite eigentlich geht, nicht das Menü, die Seitenleiste, die Fußzeile, die Kopfzeile … Dann ist das etwas, das wir berücksichtigen und versuchen diese Links zu verwenden.

Fußzeilen- und Navigationslinks sollen also weniger Gewicht haben. Und diese Tatsache wird von Zeit zu Zeit nicht nur von Google-Sprechern, sondern auch durch reale Fälle bestätigt.

In einem kürzlich von Martin Hayman bei BrightonSEO vorgestellten Fall fügte Martin den Link, den er bereits in seinem Navigationsmenü hatte, zum Hauptinhalt der Seiten hinzu. Infolgedessen verzeichneten diese Kategorieseiten und die Seiten, auf die sie verlinkten, einen Traffic-Anstieg von 25%.

Dieses Experiment beweist, dass Inhaltslinks tatsächlich mehr Gewicht haben als alle anderen.

Was die Links in der Biografie des Autors angeht, gehen SEOs davon aus, dass Bio-Links etwas wiegen, aber weniger wertvoll sind als beispielsweise Content-Links. Obwohl wir hier nicht viele Beweise haben, außer für das, was Matt Cutts gesagt hat, als Google aktiv gegen übermäßiges Gast-Blogging für Backlinks kämpfte.

John Mueller erläuterte in einem der Search Console Central-Hangouts, wie Google mit Traffic und Nutzerverhalten im Hinblick auf die Weitergabe von Linkjuice umgeht. Ein Nutzer fragte Mueller, ob Google bei der Bewertung der Qualität eines Links die Klickwahrscheinlichkeit und die Anzahl der Linkklicks berücksichtigt. Die wichtigsten Erkenntnisse aus Muellers Antwort waren:

Google berücksichtigt bei der Bewertung der Qualität des Links keine Linkklicks und Klickwahrscheinlichkeiten.

Google ist sich bewusst, dass Links häufig wie Referenzen zu Inhalten hinzugefügt werden und von Nutzern nicht erwartet wird, dass sie auf jeden Link klicken, auf den sie stoßen.

Dennoch bezweifeln SEOs wie immer, dass es sich lohnt, blind alles zu glauben, was Google sagt, und experimentieren weiter. Also haben die Leute von Ahrefs eine Studie durchgeführt, um zu überprüfen, ob die Position einer Seite auf einem SERP mit der Anzahl der Backlinks von stark frequentierten Seiten zusammenhängt. Die Studie ergab, dass es kaum einen Zusammenhang gibt. Darüber hinaus stellte sich heraus, dass einige hochrangige Seiten überhaupt keine Backlinks von verkehrsreichen Seiten hatten.

Diese Studie weist uns in eine ähnliche Richtung wie John Muellers Worte: Sie müssen keine Traffic-generierenden Backlinks zu Ihrer Seite aufbauen, um hohe Positionen in einer SERP zu erreichen. Andererseits hat der zusätzliche Traffic noch nie einer Website geschadet. Die einzige Botschaft hier ist, dass verkehrsreiche Backlinks offenbar keinen Einfluss auf das Google-Ranking haben.

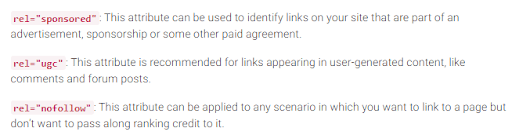

Wie Sie sich erinnern, hat Google 2005 das Nofollow-Tag eingeführt, um Link-Spam zu bekämpfen. Hat sich heute etwas geändert? Eigentlich ja.

Erstens hat Google kürzlich zwei weitere Arten des Nofollow-Attributs eingeführt. Zuvor schlug Google vor, alle Backlinks, die nicht an der PageRank-Berechnung teilnehmen sollen, als nofollow zu markieren, seien es Blog-Kommentare oder bezahlte Anzeigen. Heute empfiehlt Google die Verwendung von rel="sponsored" für bezahlte Links und Affiliate-Links und rel="ugc" für nutzergenerierte Inhalte.

Interessant ist, dass diese neuen Tags nicht obligatorisch sind (zumindest noch nicht), und Google weist darauf hin, dass Sie nicht alle rel=“nofollow“ manuell in rel="sponsored" und rel=“ugc“ ändern müssen. Diese beiden neuen Attribute funktionieren jetzt genauso wie ein gewöhnliches Nofollow-Tag.

Zweitens sagt Google jetzt, dass die Nofollow-Tags sowie die neuen Tags sponsored und ugc bei der Indexierung von Seiten als Hinweise und nicht als Anweisung behandelt werden.

Neben eingehenden Links gibt es auch ausgehende Links, also Links, die auf andere Seiten Ihrer Seite verweisen.

Viele SEOs glauben, dass ausgehende Links Auswirkungen auf das Ranking haben können, doch diese Annahme wird als SEO-Mythos abgetan. Aber es gibt eine interessante Studie, die es in diesem Zusammenhang zu sehen gilt.

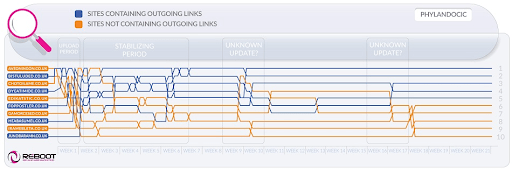

Reboot Online führte 2015 ein Experiment durch und führte es 2020 erneut durch. Sie wollten herausfinden, ob das Vorhandensein ausgehender Links zu Seiten mit hoher Autorität die Position der Seite auf einem SERP beeinflusst. Sie erstellten 10 Websites mit Artikeln mit 300 Wörtern, die alle für ein nicht existierendes Schlüsselwort optimiert waren – Phylandocic. 5 Websites hatten überhaupt keine ausgehenden Links und 5 Websites enthielten ausgehende Links zu Ressourcen mit hoher Autorität. Dies führte dazu, dass die Websites mit maßgeblichen ausgehenden Links die höchsten Plätze belegten und diejenigen, die überhaupt keine Links hatten, die niedrigsten Plätze belegten.

Einerseits können uns die Ergebnisse dieser Untersuchung zeigen, dass ausgehende Links tatsächlich die Position von Seiten beeinflussen. Andererseits ist der Suchbegriff in der Recherche brandneu und der Inhalt der Websites dreht sich um Themen rund um Medizin und Arzneimittel. Es besteht also eine hohe Wahrscheinlichkeit, dass die Abfrage als YMYL klassifiziert wurde. Und Google hat mehrfach die Bedeutung von EAT für YMYL-Websites hervorgehoben. Die Outlinks könnten also durchaus als EAT-Signal gewertet worden sein, das beweist, dass die Seiten sachlich korrekte Inhalte haben.

Was gewöhnliche Abfragen (nicht YMYL) betrifft, hat John Mueller oft gesagt, dass Sie keine Angst haben müssen, von Ihren Inhalten auf externe Quellen zu verlinken, da ausgehende Links gut für Ihre Benutzer sind.

Darüber hinaus können ausgehende Links auch für die Suchmaschinenoptimierung von Vorteil sein, da sie von Google AI beim Filtern des Webs vor Spam berücksichtigt werden können. Denn Spam-Seiten haben in der Regel, wenn überhaupt, nur wenige ausgehende Links. Sie verlinken entweder auf die Seiten unter derselben Domain (falls sie jemals über SEO nachdenken) oder enthalten nur kostenpflichtige Links. Wenn Sie also auf glaubwürdige Ressourcen verlinken, zeigen Sie Google damit, dass es sich bei Ihrer Seite nicht um Spam handelt.

Es gab einmal die Meinung, dass Google Ihnen eine manuelle Strafe auferlegen könnte, wenn Sie zu viele ausgehende Links haben, aber John Mueller sagte, dass dies nur möglich sei, wenn die ausgehenden Links offensichtlich Teil eines Link-Austauschprogramms seien und die Website im Allgemeinen davon betroffen sei schlechte Qualität. Was Google mit „offensichtlich“ meint, ist eigentlich ein Rätsel. Denken Sie also an gesunden Menschenverstand, qualitativ hochwertige Inhalte und grundlegende SEO.

Solange es PageRank gibt, werden SEOs nach neuen Möglichkeiten suchen, ihn zu manipulieren.

Im Jahr 2012 war es wahrscheinlicher, dass Google manuelle Maßnahmen gegen Linkmanipulation und Spam veröffentlichte. Mit seinen gut trainierten Anti-Spam-Algorithmen ist Google nun jedoch in der Lage, bestimmte Spam-Links bei der Berechnung des PageRanks einfach zu ignorieren, anstatt die gesamte Website generell herabzustufen. Wie John Mueller sagte:

Im Laufe der Jahre gesammelte zufällige Links sind nicht unbedingt schädlich, wir sehen sie auch schon seit langer Zeit und können all diese seltsamen Web-Graffiti von vor langer Zeit ignorieren.

Dies gilt auch für negatives SEO, wenn Ihr Backlink-Profil durch Ihre Konkurrenten kompromittiert wird:

Im Allgemeinen berücksichtigen wir diese automatisch und versuchen, sie automatisch zu ignorieren, wenn wir sie sehen. Ich vermute, dass das größtenteils ziemlich gut funktioniert. Ich sehe nur sehr wenige Menschen, die diesbezüglich tatsächliche Probleme haben. Ich denke also, dass das größtenteils gut funktioniert. Was die Ablehnung dieser Links angeht, vermute ich, dass ich mir darüber keine allzu großen Sorgen machen würde, wenn es sich nur um normale Spam-Links handelt, die nur für Ihre Website auftauchen. Wahrscheinlich haben wir das selbst herausgefunden.

Das bedeutet jedoch nicht, dass Sie sich keine Sorgen machen müssen. Wenn die Backlinks Ihrer Website zu oft und zu häufig ignoriert werden, ist die Wahrscheinlichkeit einer manuellen Maßnahme immer noch hoch. Wie Marie Haynes in ihren Ratschlägen zum Linkmanagement im Jahr 2021 sagt:

Manuelle Maßnahmen sind den Fällen vorbehalten, in denen auf eine ansonsten anständige Website unnatürliche Links in einem Ausmaß verweisen, das so groß ist, dass die Algorithmen von Google diese nicht ignorieren können.

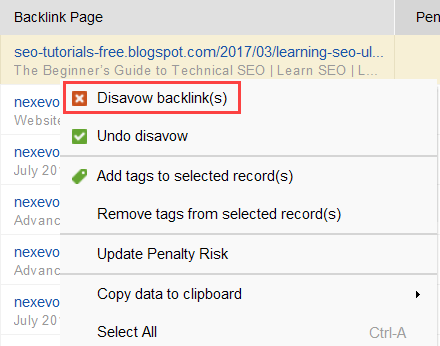

Um herauszufinden, welche Links das Problem auslösen, lesen Sie diese Anleitung zur Überprüfung der Backlink-Qualität durch. Kurz gesagt, Sie können einen Backlink-Checker wie SEO SpyGlass verwenden. Gehen Sie im Tool zum Abschnitt Backlink-Profil > Strafrisiko. Achten Sie auf Backlinks mit hohem und mittlerem Risiko.

Laden Sie SEO SpyGlass herunterUm weiter zu untersuchen, warum dieser oder jener Link als schädlich gemeldet wird, klicken Sie auf das „I“ -Zeichen in der Spalte „Strafrisiko“. Hier erfahren Sie, warum das Tool den Link als schlecht eingestuft hat, und können entscheiden, ob Sie einen Link für ungültig erklären würden oder nicht.

Laden Sie SEO SpyGlass herunterWenn Sie einen Link aus einer Gruppe von Links für ungültig erklären möchten, klicken Sie mit der rechten Maustaste darauf und wählen Sie die Option „Backlink(s) für ungültig erklären“ aus:

Sobald Sie eine Liste der auszuschließenden Links erstellt haben, können Sie die Disavow-Datei aus SEO SpyGlass exportieren und über GSC an Google senden.

Wenn wir über PageRank sprechen, können wir nicht umhin, die interne Verlinkung zu erwähnen. Den eingehenden PageRank können wir nicht kontrollieren, aber wir können die Art und Weise, wie PR auf den Seiten unserer Website verteilt wird, vollständig kontrollieren.

Auch Google hat mehrfach auf die Bedeutung interner Verlinkungen hingewiesen. John Mueller unterstrich dies noch einmal in einem der neuesten Search Console Central-Hangouts. Ein Benutzer fragte, wie man einige Webseiten leistungsfähiger machen könne. Und John Mueller sagte Folgendes:

...Sie können bei der internen Verlinkung helfen. So können Sie innerhalb Ihrer Website die Seiten, die Sie stärker hervorheben möchten, wirklich hervorheben und sicherstellen, dass sie intern wirklich gut verlinkt sind. Und vielleicht sind die Seiten, die Sie nicht so wichtig finden, intern etwas weniger verlinkt.

Interne Verlinkung hat eine große Bedeutung. Es hilft Ihnen, den eingehenden PageRank auf verschiedene Seiten Ihrer Website aufzuteilen, wodurch Ihre leistungsschwachen Seiten gestärkt werden und Ihre Website insgesamt stärker wird.

Was die Ansätze zur internen Verlinkung angeht, gibt es bei SEOs viele unterschiedliche Theorien. Ein beliebter Ansatz bezieht sich auf die Klicktiefe einer Website. Diese Idee besagt, dass alle Seiten Ihrer Website maximal 3 Klicks von der Startseite entfernt sein dürfen. Auch wenn Google schon oft die Bedeutung einer flachen Website-Struktur betont hat, scheint diese in Wirklichkeit für alle Websites, die größer als klein sind, unerreichbar zu sein.

Ein weiterer Ansatz basiert auf dem Konzept der zentralen und dezentralen internen Verknüpfung. Wie Kevin Indig es beschreibt:

Zentralisierte Websites verfügen über einen einzigen Benutzerfluss und Trichter, der auf eine Schlüsselseite verweist. Websites mit dezentraler interner Verlinkung verfügen über mehrere Conversion-Touchpoints oder unterschiedliche Anmeldeformate.

Im Falle einer zentralisierten internen Verlinkung haben wir eine kleine Gruppe von Conversion-Seiten oder eine Seite, die leistungsstark sein soll. Wenn wir eine dezentrale interne Verlinkung anwenden, möchten wir, dass alle Seiten der Website gleich leistungsstark sind und den gleichen PageRank haben, damit sie alle für Ihre Suchanfragen ranken.

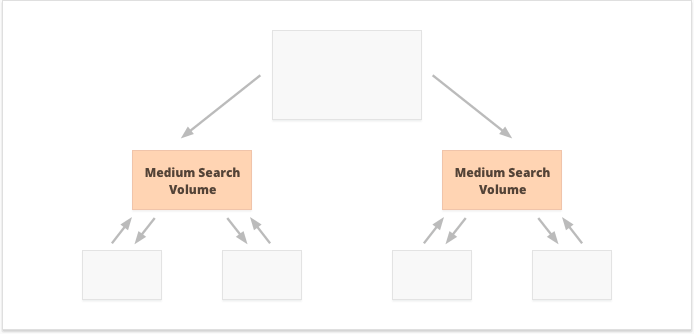

Welche Option ist besser? Es hängt alles von den Besonderheiten Ihrer Website und Ihrer Geschäftsnische sowie von den Keywords ab, auf die Sie abzielen. Eine zentralisierte interne Verlinkung eignet sich beispielsweise besser für Schlüsselwörter mit hohem und mittlerem Suchvolumen, da sie zu einer begrenzten Anzahl äußerst leistungsfähiger Seiten führt.

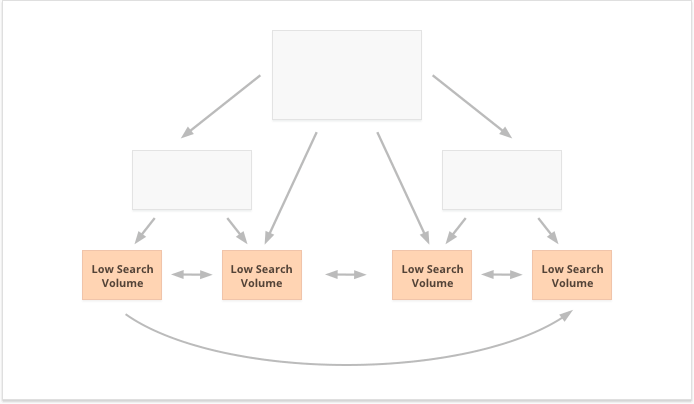

Long-Tail-Keywords mit geringem Suchvolumen eignen sich hingegen besser für die dezentrale interne Verlinkung, da sie die PR gleichmäßig auf zahlreiche Seiten einer Website verteilen.

Ein weiterer Aspekt einer erfolgreichen internen Verlinkung ist das Gleichgewicht zwischen eingehenden und ausgehenden Links auf der Seite. In diesem Zusammenhang verwenden viele SEOs CheiRank (CR), was eigentlich ein umgekehrter PageRank ist. Aber während PageRank die erhaltene Leistung ist, ist CheiRank die verschenkte Link-Leistung. Sobald Sie PR und CR für Ihre Seiten berechnet haben, können Sie sehen, welche Seiten Linkanomalien aufweisen, d. h. die Fälle, in denen eine Seite viel PageRank erhält, aber ein wenig weiter steigt, und umgekehrt.

Ein interessantes Experiment hier ist Kevin Indigs Abflachung von Link-Anomalien. Allein die Sicherstellung, dass der eingehende und ausgehende PageRank auf jeder Seite der Website ausgeglichen ist, brachte sehr beeindruckende Ergebnisse. Der rote Pfeil zeigt hier auf den Zeitpunkt, zu dem die Anomalien behoben wurden:

Linkanomalien sind nicht das Einzige, was den PageRank-Fluss beeinträchtigen kann. Stellen Sie sicher, dass Sie keine technischen Probleme haben, die Ihre hart erarbeitete PR zerstören könnten:

Verwaiste Seiten. Verwaiste Seiten sind mit keiner anderen Seite Ihrer Website verlinkt, bleiben also ungenutzt und erhalten keinen Linkjuice. Google kann sie nicht sehen und weiß nicht, dass sie tatsächlich existieren.

Weiterleitungsketten. Obwohl Google sagt, dass Weiterleitungen inzwischen 100% der PR passieren, wird dennoch empfohlen, lange Weiterleitungsketten zu vermeiden. Erstens verschlingen sie sowieso Ihr Crawling-Budget. Zweitens wissen wir, dass wir nicht alles blind glauben können, was Google sagt.

Links in nicht analysierbarem JavaScript. Da Google sie nicht lesen kann, werden sie den PageRank nicht weitergeben.

404 Links. 404-Links führen ins Nichts, also führt auch der PageRank ins Nichts.

Links zu unwichtigen Seiten. Natürlich können Sie keine Ihrer Seiten ganz ohne Links verlassen, aber Seiten sind nicht gleichwertig. Wenn eine Seite weniger wichtig ist, ist es nicht sinnvoll, zu viel Aufwand in die Optimierung des Linkprofils dieser Seite zu stecken.

Zu weit entfernte Seiten. Wenn eine Seite zu tief auf Ihrer Website liegt, wird sie wahrscheinlich wenig oder gar keine PR erhalten. Da es Google möglicherweise nicht gelingt, es zu finden und zu indizieren.

Um sicherzustellen, dass Ihre Website frei von diesen PageRank-Gefahren ist, können Sie sie mit WebSite Auditor prüfen. Dieses Tool verfügt über eine umfassende Reihe von Modulen im Abschnitt „Site-Struktur“ > „Site-Audit“, mit denen Sie die Gesamtoptimierung Ihrer Website überprüfen und natürlich alle Link-bezogenen Probleme, wie z. B. lange Weiterleitungen, finden und beheben können:

Laden Sie WebSite Auditor herunterund defekte Links:

Laden Sie WebSite Auditor herunterUm Ihre Site auf verwaiste oder zu weit entfernte Seiten zu überprüfen, wechseln Sie zu Site-Struktur > Visualisierung:

Laden Sie WebSite Auditor herunterDieses Jahr ist PageRank 23 Jahre alt geworden. Und ich schätze, es ist älter als einige unserer heutigen Leser:) Aber was kommt für PageRank in der Zukunft? Wird es eines Tages ganz verschwinden?

Wenn ich an eine beliebte Suchmaschine denke, die in ihrem Algorithmus keine Backlinks verwendet, fällt mir als einzige Idee das Yandex-Experiment aus dem Jahr 2014 ein. Die Suchmaschine kündigte an, dass das Entfernen von Backlinks aus ihrem Algorithmus Link-Spammer endlich von Manipulationen abhalten und ihre Bemühungen auf die Erstellung qualitativ hochwertiger Websites richten könnte.

Es könnte ein echter Versuch gewesen sein, sich alternativen Ranking-Faktoren zuzuwenden, oder einfach nur ein Versuch, die Massen davon zu überzeugen, Link-Spam zu löschen. Aber auf jeden Fall bestätigte Yandex nur ein Jahr nach der Ankündigung, dass Backlink-Faktoren wieder in ihrem System waren.

Doch warum sind Backlinks für Suchmaschinen so unverzichtbar?

Während es unzählige andere Datenpunkte gibt, mit denen Suchergebnisse nach Beginn der Anzeige neu angeordnet werden können (z. B. Benutzerverhalten und BERT- Anpassungen), bleiben Backlinks eines der zuverlässigsten Autoritätskriterien, die für die Bildung des ersten SERP erforderlich sind. Ihr einziger Konkurrent hier sind wahrscheinlich Unternehmen.

Wie Bill Slawski es ausdrückt, als er nach der Zukunft von PageRank gefragt wird:

Google erforscht maschinelles Lernen und Faktenextraktion sowie das Verständnis wichtiger Wertepaare für Geschäftseinheiten, was eine Bewegung in Richtung semantischer Suche und eine bessere Nutzung strukturierter Daten und Datenqualität bedeutet.

Dennoch ist Google nicht bereit, etwas wegzuwerfen, in das das Unternehmen jahrzehntelange Entwicklung investiert hat.

Google ist sehr gut in der Linkanalyse, was mittlerweile eine sehr ausgereifte Webtechnologie ist. Aus diesem Grund ist es durchaus möglich, dass PageRank weiterhin zum Ranking organischer SERPs verwendet wird.

Ein weiterer Trend, auf den Bill Slawski hinwies, waren Nachrichten und andere kurzlebige Arten von Suchergebnissen:

Google hat uns mitgeteilt, dass es sich bei Seiten, bei denen die Aktualität wichtiger ist, etwa bei Echtzeitergebnissen (z. B. von Twitter) oder bei Nachrichtenergebnissen, bei denen Aktualität sehr wichtig ist, weniger auf PageRank verlassen hat.

Tatsächlich lebt eine Nachricht viel zu wenig in den Suchergebnissen, um genügend Backlinks anzusammeln. Deshalb hat Google daran gearbeitet, Backlinks durch andere Ranking-Faktoren im Umgang mit Nachrichten zu ersetzen und wird dies auch in Zukunft tun.

Derzeit werden Nachrichtenrankings jedoch stark von der Nischenautorität des Herausgebers bestimmt, und wir interpretieren Autorität immer noch als Backlinks:

„Autoritätssignale helfen dabei, qualitativ hochwertige Informationen aus den zuverlässigsten verfügbaren Quellen zu priorisieren. Zu diesem Zweck sind unsere Systeme so konzipiert, dass sie Signale identifizieren, die dabei helfen können, anhand des Feedbacks von Suchbewertern festzustellen, welche Seiten Fachwissen, Autorität und Vertrauenswürdigkeit zu einem bestimmten Thema demonstrieren.“. Zu diesen Signalen kann gehören, ob andere Menschen die Quelle für ähnliche Suchanfragen schätzen oder ob andere prominente Websites zum Thema auf die Geschichte verlinken.“

Zu guter Letzt war ich ziemlich überrascht von den Bemühungen von Google, gesponserte und nutzergenerierte Backlinks zu identifizieren und sie von anderen Nofollow-Links zu unterscheiden.

Wenn all diese Backlinks ignoriert werden sollen, warum sollte man sie dann voneinander unterscheiden? Insbesondere nachdem John Muller angedeutet hat, dass Google später versuchen könnte, diese Art von Links anders zu behandeln.

Meine kühnste Vermutung hier war, dass Google möglicherweise prüft, ob Werbung und nutzergenerierte Links zu einem positiven Ranking-Signal werden könnten.

Schließlich erfordert Werbung auf beliebten Plattformen riesige Budgets, und riesige Budgets sind ein Merkmal einer großen und beliebten Marke.

Bei benutzergenerierten Inhalten geht es, wenn man sie außerhalb des Kommentar-Spam-Paradigmas betrachtet, um echte Kunden, die ihre Empfehlungen aus dem wirklichen Leben abgeben.

Die Experten, die ich kontaktiert habe, glaubten jedoch nicht, dass dies möglich sei:

Ich bezweifle, dass Google gesponserte Links jemals als positives Signal betrachten würde.

Die Idee hier scheint darin zu bestehen, dass Google durch die Unterscheidung verschiedener Arten von Links herausfinden möchte, welchen der Nofollow-Links zum Zweck des Entitätsaufbaus gefolgt werden soll:

Google hat kein Problem mit nutzergenerierten oder gesponserten Inhalten auf einer Website, allerdings wurden beide in der Vergangenheit als Methoden zur Manipulation des Pageranks eingesetzt. Daher wird Webmastern empfohlen, diesen Links ein Nofollow-Attribut zuzuweisen (neben anderen Gründen für die Verwendung von Nofollow). Allerdings können Nofollow-Links für Google immer noch hilfreich sein (z. B. bei der Entitätserkennung), weshalb sie dies bereits zuvor festgestellt haben Betrachten Sie dies möglicherweise eher als Vorschlag und nicht als eine Anweisung wie eine robots.txt-Disallow-Regel auf Ihrer eigenen Website. John Muellers Aussage lautete: „Ich könnte mir vorstellen, dass wir in unseren Systemen mit der Zeit lernen, sie etwas anders zu behandeln.“.“ Dies könnte sich auf die Fälle beziehen, in denen Google ein Nofollow als Vorschlag behandelt. Hypothetisch ist es möglich, dass die Systeme von Google anhand von Erkenntnissen aus den als UGC-markierten und gesponserten Linktypen lernen könnten, welchen Nofollowed-Links sie folgen sollen. Auch dies sollte keinen großen Einfluss auf das Ranking einer Website haben, könnte sich aber theoretisch auch auf die Verlinkung der Website auswirken.

Ich hoffe, es ist mir gelungen, die Rolle von Backlinks in den aktuellen Suchalgorithmen von Google zu klären. Einige der Daten, auf die ich bei der Recherche des Artikels stieß, waren selbst für mich eine Überraschung. Ich freue mich daher darauf, an Ihrer Diskussion in den Kommentaren teilzunehmen.

Haben Sie noch Fragen, auf die Sie keine Antwort haben? Haben Sie Ideen zur Zukunft von PageRank?